Meta Reality Labs 的研究人员已经创建了一款原型 VR 头戴设备,该头戴设备配备了专门用于处理 AI 处理的定制加速器芯片,从而可以在独立头戴设备上渲染公司逼真的 Codec Avatars。

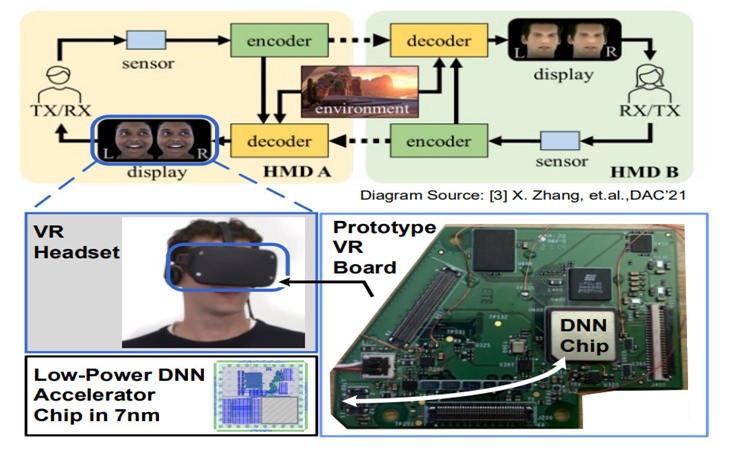

早在公司更名之前,Meta 就一直致力于其 Codec Avatars 项目,该项目旨在使 VR 中近乎照片般逼真的化身成为现实。该系统结合使用设备上的传感器(如眼动追踪和嘴巴追踪)以及 AI 处理,以逼真的方式实时为用户的详细娱乐活动制作动画。

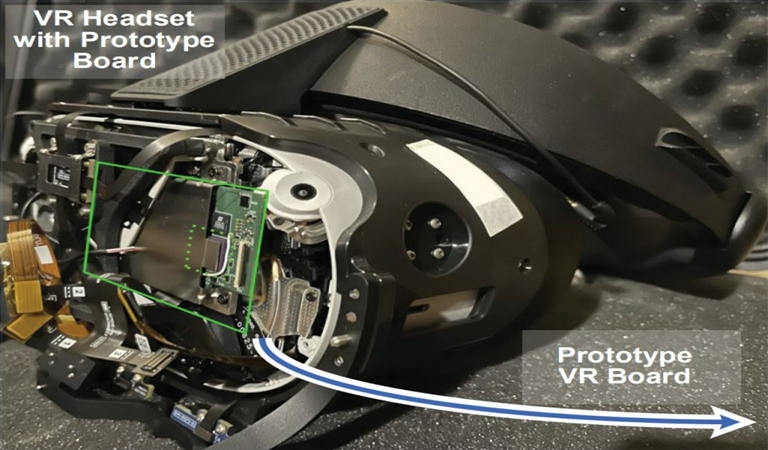

该公司的 Codec Avatars 研究的早期版本得到了 NVIDIA Titan X GPU 的强大支持,这使 Meta 最新的 Quest 2 耳机等可用的功能相形见绌。但该公司已着手研究如何在低功率独立耳机上实现 Codec Avatars,上个月在 2022 年 IEEE CICC 会议上发表的一篇论文证明了这一点。在论文中,Meta 透露它创建了一个采用 7nm 工艺构建的定制芯片,专门用作 Codec Avatars 的加速器。

据研究人员称,该芯片远未现成。该小组在设计时考虑了 Codec Avatars 处理管道的重要组成部分——特别是分析传入的眼动追踪图像并生成 Codec Avatars 模型所需的数据。该芯片的占位面积仅为 1.6mm²

“测试芯片采用 7nm 技术节点制造,具有神经网络 (NN) 加速器,由 1024 乘法累加 (MAC) 阵列、2MB 片上 SRAM 和 32 位 RISC-V CPU 组成,”研究人员写道.

反过来,他们还重建了 Codec Avatars AI 模型的一部分,以利用芯片的特定架构。“通过重新构建基于卷积 [神经网络] 的眼睛注视提取模型并针对硬件进行定制,整个模型都适合芯片,以降低片外内存访问的系统级能量和延迟成本,”Reality Labs研究人员写道。“通过在电路级有效地加速卷积运算,所展示的原型 [芯片] 实现了每秒 30 帧的性能,并且功耗低且外形小巧。”通过加速 Codec Avatars 工作负载的密集部分,该芯片不仅加快了进程,而且还降低了所需的功率和热量。由于芯片的定制设计,它能够比通用 CPU 更有效地做到这一点,然后为 Codec Avatars 的眼动追踪组件的重新架构软件设计提供信息。但耳机的通用 CPU(在本例中为 Quest 2 的 Snapdragon XR2 芯片)不会休息一天。虽然定制芯片处理部分 Codec Avatars 编码过程,但 XR2 管理解码过程并渲染化身的实际视觉效果。

令人印象深刻的是,Meta 的 Codec Avatars 可以在独立耳机上运行,即使需要专用芯片也是如此。但我们不知道的一件事是化身的视觉渲染处理得如何。用户的底层扫描非常详细,可能过于复杂,无法在 Quest 2 上完整呈现。目前尚不清楚 Codec Avatars 的“逼真”部分在这种情况下保留了多少,即使所有底层部件都在那里驱动动画。

该研究代表了新计算架构的实际应用,Reality Lab 的首席科学家 Michael Abrash最近将其描述为使 XR 的科幻愿景成为现实的必要下一步。他说,从高度集中的处理转向更分布式的处理对于此类耳机的功率和性能需求至关重要。