NeRF 指的是神经网络中的 3D 场景,一项新研究为动态场景打开了 AI 技术。

神经辐射场 (NeRF) 从图像中学习 3D 表示,然后可以渲染 3D 场景,例如从以前看不见的角度。这允许在物体周围进行 360 度摄像机移动、无人机录制游览或穿越餐厅内部。该技术还可用于生成逼真的 3D 对象。

然而,在几乎所有情况下,这些都是静态场景或物体,因为运动在训练过程中引入了迄今为止难以解决的时间维度。

在一篇新的研究论文中,来自布法罗大学、苏黎世联邦理工学院、InnoPeak 和蒂宾根大学的团队展示了 从 2D 图像中学习 4D 表示的 NeRF 动态场景。

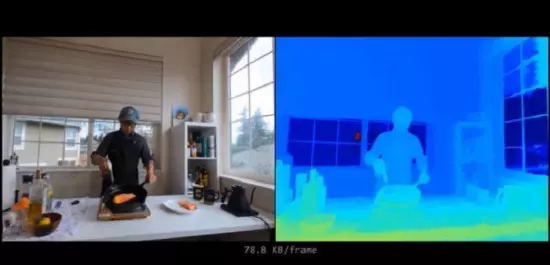

该演示以来自不同相机或单个移动相机的 RGB 图像用作输入。例如,在镜头中可以看到移动的人或有人将咖啡倒入玻璃杯中。

为了使场景可学习,团队将动态场景分为三种时态模式:静态、变形和新区域。例如,在咖啡的情况下,玻璃杯所在的木板保持静止。玻璃的内容物看起来是新的,可见的手变形了。分解场接管将场景划分为三个类别,每个区域都有专属神经域。

在他们的方法中,研究人员还分离了时间和空间维度,以改善代表性。

与其他方法相比,动态场景的分解表示显著减少了视觉伪影。该团队还使用 NeRFPlayer 来演示一种以有限比特率实时流式传输学习表示的方法。

得益于 Nvidia InstantNGP 框架,该框架允许神经网络在几秒钟内学习千兆像素图像、3D 对象和 NeRF 表示,所提出的方法也很快。

在工作中,该团队将虚拟现实的“真实 4D 时空环境”的视觉探索描述为一种愿景,并将自己的工作视为对这一目标的贡献。该论文指出:“在 VR 中自由地对真实的 4D 空间进行视觉探索是一项长期的任务。当仅使用几个甚至单个 RGB 相机来捕获动态场景时,这项任务特别有吸引力。”

我看AR登载此文出于传递更多信息的目的,并不代表本站观点,如有侵权请联系删除。